在人工智能技术日新月异的今天,AI算法的应用已经遍及各行各业,从自动驾驶到语音识别,再到数据分析和精准推荐,AI的影响力无处不在。而在国内的许多大型赛事,AI评分已经成为了衡量选手和作品质量的重要标准,尤其是在每日大赛这种高频次、大规模的比赛场景中。鲜为人知的是,AI算法评分中潜藏着许多偏差问题,这些偏差可能影响最终评定的准确性和公正性,甚至导致比赛结果的不公。

国内AI算法评分的广泛应用

在每日大赛中,AI评分系统已经成为不可或缺的组成部分。无论是编程竞赛、数据分析大赛,还是图像识别类的挑战,AI评分的引入使得比赛过程更加高效、公正。通过AI算法,评审者不再是唯一的评分主体,机器可以在几秒钟内处理大量数据,自动生成评分报告,并以此来判断参赛作品的优劣。

AI评分的应用虽然便捷,但也存在一定的局限性。许多评分系统在设计和训练过程中,存在数据偏差和算法缺陷,导致评分结果无法做到绝对的公正与精准,尤其是在面对一些复杂或边缘化的情况时,AI系统的表现往往不能如人类专家一样灵活应对。

评分偏差的根源

数据偏差(DataBias)

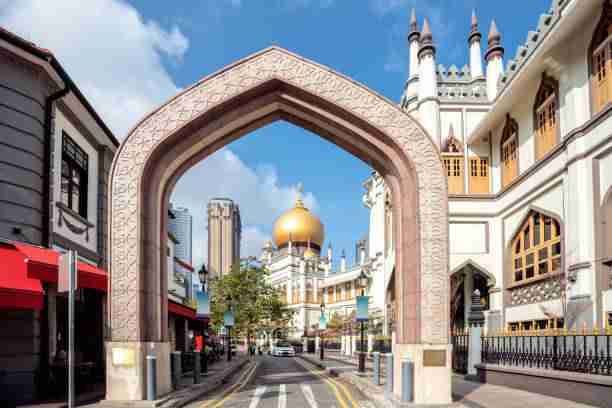

AI系统的核心在于数据,评分系统的准确性直接取决于其所依赖的数据。如果训练数据本身存在偏差,AI算法自然会带有这些偏差。例如,在一些图像识别类的比赛中,算法可能会对某些特定类型的图像表现得异常优异,而对其他类型的图像评分偏低。造成这一问题的原因,可能是训练数据集中某些类别的样本过于单一或不完整。

同样的,在编程类大赛中,如果训练数据集中出现了对某一类编程语言或算法的偏爱,AI系统便容易在评分时偏向这些特定的代码风格或技术框架,而忽略其他可能更符合实际需求的解法。

算法设计缺陷

AI评分的偏差问题不仅仅源于数据,算法本身的设计缺陷也是导致评分偏差的重要因素。一些AI评分系统的算法模型可能无法完全理解参赛作品的复杂性,尤其是在创意类比赛中。虽然AI可以高效地识别和评估标准化的内容,但对于一些具有高度创造性、非传统结构的作品,AI算法可能会因为模型的局限性而无法做出恰当的评价。

例如,在创意编程竞赛中,某些具有突破性思维的解决方案可能无法被AI系统识别为优胜者,因为这些方案在算法评分体系中并不符合常规的“高分”标准。此时,AI评分的准确性便受到质疑,甚至可能错失许多具有潜力的创新作品。

训练模型的局限性

AI算法是通过大量的历史数据进行训练的,而这些历史数据反映的只是过去的评分趋势和模式。如果训练数据中的一些极端案例或不常见情况没有得到足够的考虑,那么AI系统在面对类似情况时,便可能做出错误的判断。这种偏差在每日大赛的动态评分中尤为明显,尤其是在一些高度创新或极具挑战性的赛事环节中,AI评分系统可能无法及时做出调整,导致评分结果的不准确。

模型过度依赖统计特征

许多AI评分系统在设计时会对参赛作品进行大量的量化分析,依靠统计学特征(如代码行数、执行效率、图像清晰度等)来打分。这种方法虽然可以较为客观地评估某些方面的优劣,但它忽略了创意、情感表达等更为抽象的评价标准。例如,在一场编程大赛中,AI系统可能会给出一段代码高分,因为它符合某些标准化的优化规则,但忽视了代码的可读性和其他开发者可能面临的实际应用场景。

人工干预的不足

尽管AI算法在评分时表现出强大的计算能力,但在面对一些极端或特殊情况时,仍需要人工的干预和调整。许多AI评分系统缺乏对比赛细节的深入理解,尤其是在一些具有复杂背景或特殊要求的比赛环节中,算法往往无法准确判断每个作品的独特性和创意。缺乏人工干预的评分系统容易造成评判结果的单一化,从而影响比赛的公平性和多样性。

如何应对AI评分偏差?

面对AI评分系统中的偏差问题,我们如何才能优化算法,使得评分更加公正和准确呢?算法设计者需要从数据源、模型设计以及人工干预等多个方面入手,全面提升AI评分系统的能力。

优化数据集

通过对训练数据进行多样化和全面性优化,避免数据中的单一偏向和不完全性。对于不同领域的比赛,数据集应当涵盖尽可能广泛的样本,以避免因样本量不足而产生偏差。在数据标注过程中,确保每个标签都具有足够的代表性,以提高训练模型的准确性。

增强算法的灵活性和泛化能力

AI评分系统的算法设计需要更加注重灵活性和泛化能力,特别是对于创意类和复杂问题的评估,AI应该能够更好地适应不同类型作品的多样性。设计者应当在训练过程中考虑到各种可能出现的特殊情况,避免过度依赖传统的评分标准。

引入人工智能与人工评审的结合

虽然AI评分系统具有高效性,但它无法完全替代人工评审,尤其是在一些非常复杂的比赛环节中。因此,将AI评分与人工评审相结合,形成双重评价机制,可以弥补算法的局限性,提高评分的准确性和全面性。